Google a lancé en début de mois aux US sa librairie en ligne Google eBooks : en France, sa relation avec les éditeurs (sauf Hachette) et les pouvoirs publics est connue pour n’être pas au beau fixe. Aujourd’hui, Google prétend aussi pouvoir se servir de son fond numérisé de plus de 5 millions de livres, pour explorer les sciences humaines.

L’enjeu derrière l’édition numérique, et le rôle leader que Google veut s’y donner, est à double échelle.

Il n’est pas juste de « mettre la culture à la portée de tous » : permettre à Monsieur (ou Madame) Tout le Monde de consulter de son fauteuil 3 millions de livres, même ce manuscrit du XXe siècle contenant des scholies écrites 15 siècles plus tôt et relatives à des textes déjà antérieurs de 5 siècles (source blog Google).

Il s’agit aussi de créer et centraliser les outils et services qui vont permettre d’analyser cette culture. Explorer les tendances culturelles. C’est ce que vise l’outil lab Ngram Viewer, grâce à ces 5.200.000 livres déjà numérisés : 4% de tous les ouvrages jamais imprimés dans le monde .

Google avait initié il y a quelques mois un programme d’encouragement à exploiter la richesse de son fonds numérisé. Cet article d’Hubert Guillaud sur le Monde, qui en présente quelques projets, vous montrera plus largement en quoi les « digital humanities » (les pratiques des sciences humaines et sociales, en interaction avec les données, la documentation et l’édition numérique) sont le pan émergent des sciences humaines, auquel la performance des technologies apporte usages et éclairages nouveaux.

« Culturomics » (culture + genomics), mot-valise imaginé par l’équipe, désigne un projet initié par Google dans ce cadre d’actions. L’article fondateur publié dans Science, explique comment cette volumétrie autorise une approche qui étend le champ de l’analyse quantitative à des phénomènes relevant des sciences humaines et sociales. C’est dans ce cadre que s’inscrit le service Ngram Viewer.

Ngrams, le plus grand corpus de tous les temps : 500 milliards de mots

Pour l’utilisateur néophyte, Ngram est un outil sympa, avec une interface simplificatrice. Vous saisissez de 1 à 5 mots et observez leur évolution d’usage au fil du temps (de 1800 à 2008), en fonction de leur occurrence dans les ouvrages numérisés. Ça peut aider à réinventer la roue (ou bien au contraire à moins s’en soucier !)

On y découvre par exemple que le monde change décidément beaucoup, et de plus en plus vite !

Mais ses préoccupations jusqu’ici nous rassurent, plutôt :D

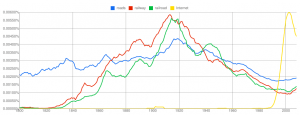

Il y a des essais amusants à faire sur l’évolution des réseaux, je vous en livre au hasard un que j’ai trouvé assez joli (testez aussi les occurrences du mot « network / réseau »)

Et il n’est pas inintéressant d’observer aussi les formes de perception du « savoir », celles analytiques devant fatalement prendre le pas sur celles consolidées. Quand on vous dit que le « par cœur » à l’école ne saura bientôt plus où donner de la tête, avec cette masse de données. ;)

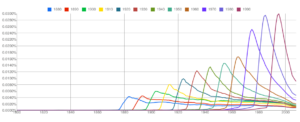

Comme l’explique Boing-boing, les chercheurs ont pu ainsi faire émerger des modèles et hypothèses réellement intéressants. Les mentions des années (vous pouvez facilement reproduire cette observation, qui dessine un très beau modèle), ou celles des inventions, questionnent sur notre propension à oublier de plus en plus vite notre passé (la demi-vie des courbes est de plus en plus brève) et à ancrer de plus en plus vite et facilement notre futur.

Une fiabilité imparfaite, mais des données ouvertes

Du point de vue du spécialiste, en revanche, l’outil est loin de la perfection.

La faible qualité de l’OCR (reconnaissance des caractères : confusion par exemple entre le s long – ancienne forme du s minuscule – et le f) est notamment en cause : et pour avoir décrypté pas mal de documents anciens – et l’avis est celui de tous les spécialistes ici et là sur Internet -, c’est un handicap de taille.

Sans compter des biais dus aux erreurs de datations, un certain « bruit » provoqué par les rééditions d’ouvrages, etc. Si vous voulez approfondir les faiblesses du corpus, vous trouverez ici un comparatif avisé avec le COHA (Corpus of Historical American English).

En bref, la donnée est là, mais sa faculté d’exploitation laisse encore à désirer. :)

Mais la démarche à retenir, est l’inscription dans la tendance de « libération des données » (Cf. raw datas now, intervention de Tim Berners Lee, inventeur d’Internet) : la libre mise à disposition du public et des chercheurs d’un corpus d’une taille phénoménale.

Il n’est pas ici livré « brut », mais sous la forme de ses n-grammes (les séquences de n mots consécutifs, n de 1 à 5). Mais comme le relève Rémi Mathis, le tout est placé sous la licence Creative Commons BY, la plus ouverte, ce qui encourage les initiatives innovantes, y compris commerciales, qui sauraient tirer parti de cette mine d’informations.

Reste à savoir ce que pensent les chercheurs en sciences sociales de cette « dépendance » à Google : bénéfice ou contrainte ?

Peut-on quantifier l’humain ?

On s’attend à peu d’affinités et beaucoup de craintes, avec ce type d’approche : on touche à « l’humain ».

Mais de même qu’au quotidien on l’observe par exemple, pour le data-journalisme (qui fait travailler main dans la main journalistes et statisticiens, infographistes, développeurs…), Internet semble avoir décidément cette faculté à décloisonner les spécialités, et à rapprocher les geeks… et les autres.

Comme Chris Anderson l’expliquait il y a quelques mois, le déluge de données va bouleverser l’approche et la méthode scientifiques. La corrélation (le lien transversal) est en train de trouver sa valeur face à la causalité. (J’en reparlerai dans un prochain billet, mais on voit d’ailleurs de plus en plus clairement, tomber les frontières entre les disciplines, s’effacer « l’effet de silo » qui a compartimenté les sciences, l’académisme, l’enseignement…)

Les spécialistes en sciences humaines, les historiens, interrogés par Patricia Cohen pour le New York Times, y voient surtout des potentialités de développement : l’émergence de nouvelles caractéristiques, sources d’études, de nouveaux questionnements, sujets de recherches…

Le risque pour eux ne repose pas tant sur la quantification des données, que sur la qualité de l’interprétation et de l’usage : elle est affaire d’humains, et de professionnels (prudence évidemment avec le genre de tentatives ludiques comme ci-dessus !). Et il est à parier que ces données, ces outils, vont justement leur apporter sinon un matériau nouveau, du moins un angle d’attaque inédit jusqu’ici, et encore inconcevable il y a peu.

Mais je vous invite aussi à lire le billet d’Olivier Ertzscheid sur Affordance, qui en interrogeant sur la notion de corpus, notamment sous l’angle du droit, et en rapprochant ce corpus linguistique du corpus social de Facebook, éclaire aussi très bien les dimensions vertigineuses prises par ce jeu de l’apprenti sorcier.

Tout cela revient à dé-re-matérialiser, à une autre échelle, ce qui est du domaine du culturel, immatériel : l’intelligence humaine en train de se corporifier… dans les mains de qui ?

4 commentaires sur “Culturomics. Google met la culture à portée de tous… ou corporifie la culture humaine ?”

Si vous souhaitez profiter des largesses du pouvoir, allez vous voter pour des incorruptibles ou pour des pourris ?